Le compromis de l'ubiquité

En bref

- La connectivité omniprésente est un objectif inaccessible aux États-Unis, malgré des centaines de milliards d'investissements.

- Les exigences irréalistes du réseau en matière d'applications en sont l'une des raisons.

- Les réseaux à large bande passante et à forte latence utilisant diverses stratégies de placement des données, notamment la mise en cache, les réseaux de diffusion de contenu et le traitement local, peuvent constituer une solution économique pour la plupart des cas de connectivité critiques.

Les lois de la logique et de la nature limitent souvent notre capacité à réaliser ce que nous voulons. Cela a été particulièrement le cas pour la connectivité omniprésente, un objectif de longue date de la communauté de recherche appliquée sur les réseaux aux États-Unis, pour lequel le gouvernement a fourni 100 milliards de dollars en programmes d'investissement et un montant bien plus important de la part du secteur privé.

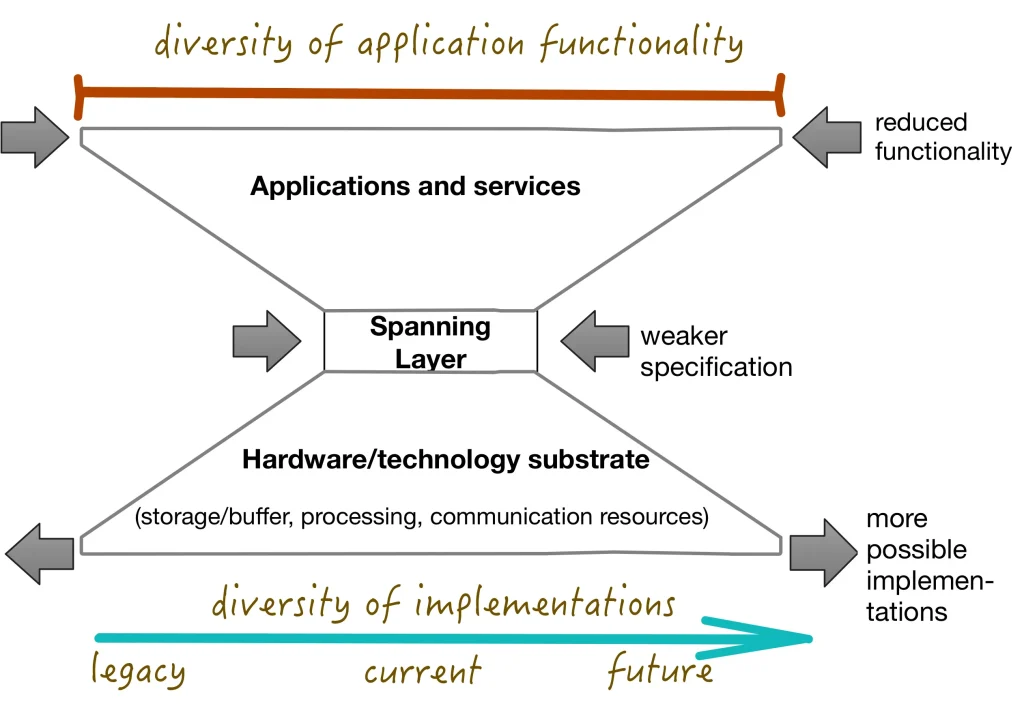

Le compromis de l'ubiquité est une loi logique qui nous renseigne sur la relation entre la force logique de la définition de "connecté au sein d'un réseau" et le potentiel de déploiement ubiquitaire de ce réseau. Un résultat formel connu sous le nom de théorème du sablier (figure 1) nous indique que plus la définition de la connectivité est logiquement faible, plus il y a de façons de la mettre en œuvre. Un plus grand nombre d'implémentations signifie qu'il sera plus facile d'atteindre certaines caractéristiques souhaitables, telles qu'un faible coût ou une grande fiabilité. En définitive, un service logiquement plus fort aura moins de chances de devenir omniprésent.

La force logique n'est pas toujours un concept intuitif. Un service est logiquement fort si sa définition, exprimée dans un cadre logique, offre de nombreuses garanties. Un service qui offre moins de garanties est logiquement faible. Cela semble parfois intuitif. Par exemple, un service de réseau qui garantit une livraison fiable est plus fort qu'un service de type "best-effort". Inversement, un réseau qui garantit une accessibilité universelle entre deux nœuds est plus fort qu'un réseau qui autorise une accessibilité partielle. Cela signifie qu'un Internet qui autorise la traduction d'adresses de réseau (NAT) est logiquement plus faible qu'un Internet qui ne l'autorise pas.

La définition de la connectivité dans un réseau spécifie le service minimum requis pour prendre en charge les applications connectées standard. L'utilisation de ce seul niveau de service garantit qu'une application peut être déployée sur l'ensemble du réseau. Le compromis d'ubiquité nous indique qu'une stratégie permettant à un réseau d'être ubiquitaire consiste à adopter une définition suffisamment faible de la connectivité.

Un exemple typique d'exigences fortes rendant une application moins largement déployable est la dépendance à l'égard de la vidéoconférence interactive à haute définition. Une application répondant à cette exigence ne peut pas être déployée dans des environnements où les performances du réseau sont médiocres ou très variables. Un environnement de réseau qui exige les garanties nécessaires pour soutenir cette application sera plus difficile et plus coûteux à mettre en œuvre, ce qui réduira la pénétration.

Il existe d'autres stratégies pour affaiblir la définition de la connectivité. Une solution évidente consiste à augmenter le temps de latence. Techniquement, même la connectivité Internet à large bande n'impose aucune limite spécifique à la latence. Toutefois, les accords sur les niveaux de service et l'exigence générale que les "protocoles interactifs" soient pris en charge ont pour effet d'exclure le recours à des mécanismes de transmission de données hautement asynchrones.

Un article récent que j'ai cosigné avec Terry Moore, intitulé"Is Universal Broadband Service Impossible ?", examine dans quelle mesure il est possible d'obtenir des fonctionnalités à partir d'un réseau à large bande et à forte latence en utilisant diverses stratégies de placement des données, notamment la mise en cache, les réseaux de diffusion de contenu et le traitement local.

La latence élevée est incompatible avec les stratégies axées sur les services à latence ultra-faible pour répondre aux besoins des applications les plus exigeantes (et les plus lucratives), mais elle n'est pas une exigence réelle pour la plupart d'entre elles. Il s'agit notamment de la télésanté, du travail et de l'enseignement à distance, de l'entrepreneuriat par le biais de plateformes telles qu'Etsy, et de l'échange d'informations agricoles. Toutes ces applications peuvent être mises en œuvre de manière très utile en combinant des communications à haute latence avec un stockage et un traitement locaux.

Oui, le service de réseau est meilleur lorsqu'il offre des garanties solides aux utilisateurs finaux. Mais parfois, nous obtenons ce dont nous avons besoin, ce qui n'est pas nécessairement ce que nous voulons.

Les grandes entreprises technologiques ont bien profité de l'affirmation selon laquelle la fourniture d'une excellente large bande était la seule solution acceptable pour répondre aux besoins de connectivité du monde. Aujourd'hui, elles se tournent vers une nouvelle panacée: l'intelligence artificielle sous la forme de grands modèles linguistiques. Il est peut-être temps de se demander comment nous pouvons réellement répondre au véritable besoin de connectivité de base du monde : une livraison de datagrammes moins synchrone dans le monde entier à un coût vraiment minime !

Micah D. Beck est professeur associé au département de génie électrique et d'informatique de l'université du Tennessee.

Ce billet a été adapté à partir de l'original, qui a été publié pour la première fois sur le Blog de Communications of the ACM.

Les opinions exprimées par les auteurs de ce blog sont les leurs et ne reflètent pas nécessairement celles de l'Internet Society.