El compromiso de la ubicuidad

En resumen

- La conectividad ubicua ha sido un objetivo inalcanzable en EE.UU., a pesar de los cientos de miles de millones invertidos.

- Los requisitos poco realistas de las aplicaciones de la red son una de las razones.

- Las redes de gran ancho de banda y alta latencia que utilizan diversas estrategias de colocación de datos, como el almacenamiento en caché, las redes de distribución de contenidos y el procesamiento local, pueden ofrecer una solución económica para la mayoría de los casos de conectividad crítica.

Las leyes de la lógica y de la naturaleza a menudo limitan nuestra capacidad para lograr lo que queremos. Éste ha sido particularmente el caso de la conectividad ubicua, un objetivo de larga data de la comunidad de investigación aplicada a las redes en EE.UU., para el que el Gobierno ha aportado 100.000 millones de dólares en programas de inversión y una cantidad significativamente mayor por parte del sector privado.

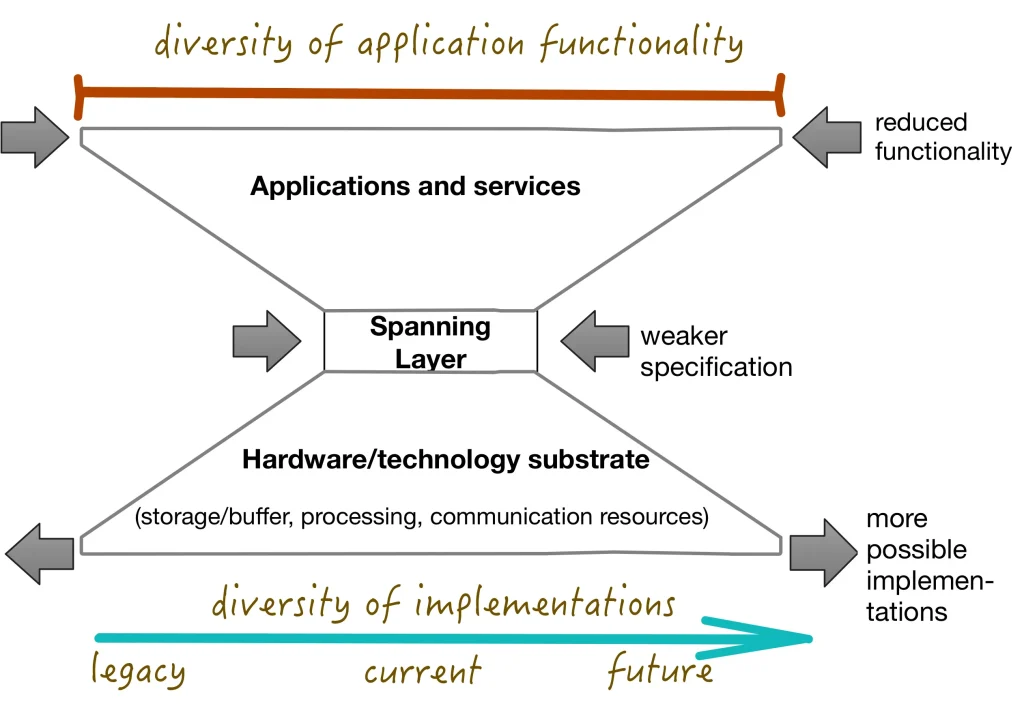

El compromiso de ubicuidad es una ley lógica que nos dice algo sobre la relación entre la fuerza lógica de la definición de "conectado dentro de una red" y el potencial de despliegue ubicuo de esa red. Un resultado formal conocido como el Teorema del Reloj de Arena (Figura 1) nos dice que cuanto más débil lógicamente sea la definición de conectividad, más formas habrá de implementarla. Un mayor número de implementaciones posibles significa que será más fácil conseguir algunas características deseables, como un bajo coste o una alta fiabilidad. La conclusión es que un servicio lógicamente más fuerte tendrá menos probabilidades de convertirse en omnipresente.

La solidez lógica no siempre es un concepto intuitivo. Un servicio es lógicamente fuerte si su definición, expresada en algún marco lógico, ofrece muchas garantías. Un servicio que hace menos garantías es lógicamente débil. A veces esto parece intuitivo, por ejemplo, un servicio de red que garantiza una entrega fiable es más fuerte que uno de mejor esfuerzo. A la inversa, una red que garantiza la alcanzabilidad universal entre dos nodos cualesquiera es más fuerte que una que permite la alcanzabilidad parcial. Eso significa que una Internet que permite la traducción de direcciones de red (NAT) es lógicamente más débil que una que no lo hace.

La definición de conectividad en una red especifica el servicio mínimo que se requiere para soportar aplicaciones conectadas estándar. Utilizar sólo este nivel de servicio garantiza que una aplicación pueda desplegarse en toda la red. El compromiso de ubicuidad nos dice que una estrategia para permitir que una red sea ubicua es adoptar una definición de conectividad suficientemente débil.

Un ejemplo típico de requisitos estrictos que hacen que una aplicación sea menos desplegable ampliamente es la dependencia de videoconferencias interactivas de alta definición. Una aplicación con este requisito no puede desplegarse en entornos en los que el rendimiento de la red sea deficiente o muy variable. Un entorno de red que exija las garantías necesarias para soportar este requisito de la aplicación será más difícil y costoso de implantar, lo que reducirá su penetración.

Existen otras estrategias para debilitar la definición de conectividad. Una solución obvia es aumentar la latencia. Técnicamente, ni siquiera la conectividad a Internet de banda ancha pone límites específicos a la latencia. Sin embargo, los acuerdos de nivel de servicio y el requisito general de que deben admitirse "protocolos interactivos" tienen el efecto de descartar la dependencia de mecanismos de entrega de datos altamente asíncronos.

Un reciente artículo del que soy coautor con Terry Moore,"¿Es imposible el servicio universal de banda ancha?", examina hasta qué punto se puede conseguir la funcionalidad de una red de gran ancho de banda y alta latencia utilizando diversas estrategias de colocación de datos, como el almacenamiento en caché, las redes de distribución de contenidos y el procesamiento local.

La alta latencia es incompatible con las estrategias centradas en un servicio de latencia ultrabaja para satisfacer las necesidades de las aplicaciones más exigentes (y más lucrativas), pero no es un requisito real para la mayoría. Entre ellas se encuentran la telesalud, el trabajo y la educación a distancia, el emprendimiento a través de plataformas como Etsy y el intercambio de información agrícola. Todas ellas pueden implementarse de formas muy útiles combinando la comunicación de alta latencia con el almacenamiento y el procesamiento locales.

Sí, el servicio de red es mejor cuando ofrece garantías sólidas a los usuarios finales. Pero a veces obtenemos lo que necesitamos, que no es necesariamente lo que queremos.

Las grandes empresas tecnológicas han tenido un buen paseo con la afirmación de que proporcionar una excelente banda ancha era la única solución aceptable a las necesidades de conectividad del mundo. Ahora están pasando a una nueva panacea: la inteligencia artificial en forma de grandes modelos lingüísticos. Quizá haya llegado el momento de preguntarse cómo podemos atender realmente la verdadera necesidad de conectividad básica del mundo: ¡una entrega de datagramas menos sincrónica en todo el mundo a un coste realmente mínimo!

Micah D. Beck es profesor asociado del Departamento de Ingeniería Eléctrica e Informática de la Universidad de Tennessee.

Este post ha sido adaptado del original, que apareció por primera vez en el blog Communications of the ACM.

Las opiniones expresadas por los autores de este blog son suyas y no reflejan necesariamente los puntos de vista de la Internet Society.